Was bedeutet der AI Act für Unternehmen?

veröffentlicht: 1. August 2024 – Update: 12. Mai 2025

Seit Anfang 2025 gelten zahlreiche neue Regeln für den Einsatz von Künstlicher Intelligenz, einschließlich Generativer KI – auch für Unternehmen. Unsere FAQs zum AI Act liefern Orientierung in 14 Fragen und Antworten und werden regelmäßig aktualisiert. Hier erfahren Sie:

- Welche Verpflichtungen jetzt auf Firmen zukommen

- Wie Sie das Gesetz einhalten, ohne zu viel Bürokratie aufzubauen

- Wie das Gesetz sogar helfen kann, mehr Geschäft zu generieren

1. Wie ist der AI Act für Unternehmen generell zu bewerten?

Das Gesetzeswerk ist viel kritisiert worden, weil eine zu starke KI-Regulierung die europäische Wirtschaft gegenüber dem Rest der Welt benachteilige. Es würde Innovationen ausbremsen, warnen Kritiker, und dazu führen, dass – wie bei früheren Technologiesprüngen – auch nun wieder die wichtigen Anwendungen allein von den großen IT-Konzernen aus den USA und China entwickelt würden.

Diese Argumentation ignoriert jedoch, dass Regulierung – in einem angemessenen Maße – kein Hemmschuh ist: Im Gegenteil gibt sie der Wirtschaft rechtliche Sicherheit und damit strategische Klarheit, wo es sich lohnt, zu investieren, und welche Geschäftsmodelle Zukunft haben. Das zu betonen, wird auch Ursula von der Leyen, die Präsidentin der Europäischen Kommission, nicht müde:

„Die Einigung konzentriert die Regulierung auf erkennbare Risiken, schafft Rechtssicherheit und ebnet den Weg für Innovationen im Bereich der vertrauenswürdigen Künstliche Intelligenz.“

Ursula von der Leyen, EU-Kommissionspräsidentin

Dazu kommt das moralische Gebot, KI zu kontrollieren: Zu viele „Deep Fakes“ haben gezeigt, wie die Technologie missbraucht werden kann – man denke an Olaf Scholz’ angebliche AfD-Beschimpfungen, die Fake-Explosion am Pentagon oder Präsident Selenskyjs scheinbarer Aufruf zur Kapitulation der Ukraine. Das Ziel, die Menschheit vor gefährlichen Auswüchsen von KI zu schützen, ist im Gesetzestext daher auch vielfach sichtbar.

Grundsätzlich ist der AI Act der EU für Unternehmen hilfreich, um die Weiterentwicklung von verlässlicher und vertrauenswürdiger KI-Technologie zu fördern – weil es Innovation rechtssicher und damit auch„versicherbar“ macht. Auch Google-Chef Sundar Pichai hat das explizit in einem FT-Gastbeitrag betont:

„Europe’s AI Act is an important development in balancing innovation and risk.“

Sundar Pichai, Google-CEO

Kritiker:innen monieren, das genau diese „Balance“ nicht mehr gegeben sei und zu pauschale Vorgaben Innovationen bremsen würden. Und tatsächlich erleben wir bereits in Projekten, dass die EU-Regulierung teilweise Unsicherheiten eher erhöht, als Orientierung zu geben: „Wenn wir mit einem Kunden ein KI-Produkt aufbauen, können wir genau ausrechnen, wie viel das kostet“, hat es unser Geschäftsführer Timm Rotter im Interview mit der österreichnischen Zeitung „Der Standard“ formuliert. Viel weniger kalkulierbar sei hingegen, ob es im letzten Detail den gesetzlichen Anforderungen der EU standhält: Und diese Unsicherheit bremst Innovation – und damit im letzter Instanz auch die europäische Wettbewerbsfähigkeit.

2. Welche KI-Anwendungen werden im KI-Gesetz der EU reguliert?

Eine einfache White- oder Blackliste existiert nicht, daher sollte man die Grundidee des Gesetzes verstehen. Es sortiert KI-Anwendungen nach Risikokategorien, wie auch unsere Grafik zeigt:

- unzulässige Anwendungen, die vollständig verboten sind (Art. 5). Darunter fallen in der EU etwa Social-Scoring-Systeme oder Gesichtserkennung zur Fernüberwachung. Ebenfalls verboten wird „Predictive Policing“ auf Basis persönlicher Merkmale, wie der Hautfarbe, also der Einsatz von KI, um abzuschätzen, ob eine Person eine Straftat zukünftig begehen wird oder nicht. Der letztgenannte Case ist aus Firmensicht sicherlich nicht realistisch, er bringt aber die wichtigste Leitlinie des AI Acts zum Ausdruck: KI darf Menschen auf keinen Fall schaden.

- Hoch-Risiko-KI, für die sehr klare Dokumentationspflichten gelten – in Unternehmen dürfte dies bspw. relevant werden im Personalbereich (siehe unten)

- Anwendungen mit Transparenz- und Kennzeichnungspflicht – alle KI-Systeme, die zur unmittelbaren Interaktion mit Menschen gedacht sind, verortet der AI Act mindestens auf dieser Stufe. Dazu zählen Chatbots und die meisten der gängigen GenAI-Tools.

- unkritische Anwendungen, die keiner Regulierung unterliegen. Hierunter dürften die meisten KI-Anwendungen fallen, die wir im Alltag gar nicht als solche im Blick haben – etwa Spamfilter oder Speech-to-Text-Funktionen am Handy.

3. Welche KI-Systeme mit hohem Risiko gibt es in Unternehmen?

Unter Hoch-Risiko-KI fallen laut AI Act (Art. 6) Anwendungen, deren Einsatz „Gesundheit, Sicherheit oder Grundrechte von Menschen gefährden“ könnten. Unternehmen sollten hier vor allem auf KI im Kundenservice und im HR-Bereich schauen:

- Im Kundenservice könnten KI-Systeme z. B. Reklamationen vorsortieren und – abhängig vom Kundenprofil – bewerten. Dies könnte Grundrechte betreffen, weil die KI hier gewisse Personen bevorzugen oder benachteiligen könnte.

- Im HR-Bereich gilt ähnliches – im Recruiting wie auch in der Personalentwicklung: Man denke an einen KI-Bot, der als erste Instanz alle Bewerbungen screent und nur Kandidat:innen an die menschlichen HR-Kolleg:innen weiterreicht, die das System als geeignet ansieht. Gleiches ist bei der Entscheidung über Beförderungen oder bei der Leistungskontrolle von Arbeitnehmer:innen denkbar – im schlechtesten Fall bis hin zu disziplinarischen Maßnahmen, wo der Bot zumindest Empfehlungen aussprechen könnte.

All diese Anwendungen sind nicht verboten, aber es gibt klare Transparenz- und Dokumentationspflichten für Unternehmen.

Bevor der oben beschriebene Recruiting-Bot im HR-Team also eine Bewerbung zu lesen bekäme, müsste die oder der Kandidat:in dies zuvor erfahren und dem vermutlich sogar zustimmen. Weitere Vorgaben für den Betrieb von Hochrisiko-KI sind im AI Act beschrieben – etwa sehr klare Dokumentationen und dass immer menschliche Aufsicht und Eingriffe möglich sind.

4. Welche Anforderungen, was KI-Transparenz angeht, betreffen Unternehmen?

Wichtig sind hier vor allem zwei Aspekte in der Nutzung von KI, die der AI Act in Artikel 50 nennt:

- Auf der Ebene der Tools geht es um Anwendungen, die für die Interaktion mit Menschen bestimmt sind, wie z. B. KI-basierte Chatbots. Sie müssen so konzipiert sein, dass die Nutzer:innen erfahren, dass sie mit einem KI-System interagieren. Die Verpflichtung, die Transparenz sicherzustellen, liegt zunächst bei denjenigen Firmen, die die Systeme anbieten (im KI-Gesetz „provider“ genannt). Unternehmen, die sie im eigenen beruflichen Alltag anwenden (die „deployer“) sind jedoch auch in der Bringschuld. Und zwar hinsichtlich Punkt 2:

- Firmen, die Inhalte mithilfe von KI erstellen – ob Audio, Bild, Video oder Text – müssen sicherstellen, dass diese als künstlich erzeugt oder von KI manipuliert erkannt werden können. Dies gilt für alle KI-Inhalte, nicht nur für „Deep Fakes“, also künstlich generierte Inhalte, die realen Menschen, Orten oder Dingen so präzise nachempfunden sind, dass man sie von diesen nicht oder kaum unterscheiden kann.

Allerdings: Es gibt eine sehr wichtige Ausnahme, mitten drin in Artikel 50, Absatz 2: „Diese Verpflichtung (zur KI-Transparenz)“, heißt es dort, „gilt nicht, soweit die KI-Systeme eine Hilfsfunktion für die Standardredaktion erfüllen oder die vom Anwender bereitgestellten Eingabedaten oder deren Semantik nicht wesentlich verändern“. Was das heißt, beantworten wir unter der folgenden Frage.

5. Muss man fortan alle mit KI erzeugten Inhalte kennzeichnen?

Diese Frage treibt viele unserer Kunden um, und wie gerade schon bei der Betrachtung von Artikel 50 beschrieben, ist die Antwort nicht eindeutig. Zunächst: Die Kennzeichungspflicht greift erst ab August 2026. Dennoch lohnt es, jetzt schon intern zu sensibilisieren und die nötigen Vorbereitungen zu treffen.

Die Grundregel ist einfach: Content, der aus der KI stammt, muss als solcher erkennbar sein. Allerdings schränkt der AI Act explizit ein, dass dies in zwei Fällen nicht gilt,

- „soweit die KI-Systeme eine Hilfsfunktion für die Standardredaktion erfüllen“ oder

- „die vom Anwender bereitgestellten Eingabedaten oder deren Semantik nicht wesentlich verändern“.

„Der Begriff ,Hilfsfunktion‘ ist hier ganz relevant – darauf verweisen zumindest Juristen, mit denen wir sprechen“, sagt disruptive-Geschäftsführer Timm Rotter. „Will heißen: Wenn Ihre menschliche Leistung in der Content-Erstellung maßgeblich ist und Sie das jeweiligen KI-Tool nur nutzen, um das Ergebnis in Teilen oder in einer bestimmten Dimension zu verbessern, besteht keine Transparenzpflicht.“ Vier Beispiele:

- Sie schreiben eine Redeskript für Ihre CEO. Den Text lassen Sie am Ende von Perplexity nochmals faktenchecken.

- Sie bedienen sich der Photoshop-KI, um per „Generative Filling“ das hässliche Auto aus dem Sommerfest-Gruppenfoto rauszuretuschieren, das gerade im falschen Moment hinten durchs Bild fahren musste.

- Sie verwenden Microsoft Copilot, um eine Tabelle mit Verkaufszahlen als Grafik darzustellen und zudem Muster in den Daten zu erkennen.

- Sie nutzen ChatGPT, um für das Vorstellungsgespräche mit dem Kandidaten für die IT-Leitung noch ein paar besondere Fragen zur Hand zu haben.

In allen vier Fällen ist die KI-Leistung der menschlichen Intelligenz untergeordnetet. Daher: Ausweisen müssen Sie die Rolle der KI hier nicht.

Wir empfehlen unseren Kunden:innen dennoch, bei GenAI-Produkten sehr transparent zu sein – und das aus zwei Gründen:

- zum einen, weil viele Nutzer:innen dies erwarten

- zum anderen, weil es auch ein Statement für die eigene Modernität und damit ein Beitrag zum Markenimage sein kann, wenn man KI einsetzt.

Wichtig zu wissen: Neben dem KI-Gesetz gibt es noch andere Rechtsvorschriften, die GenAI beeinflussen. Dazu zählen Persönlichkeitsrechte oder Urheberrechte – diese gelten natürlich weiterhin. Vor allem bei GenAI und Urheberrecht tritt man schnell in rechtliche Fettnäpfchen.

Mehr KI-Updates gefällig?

In unserem monatlichen Newsletter erhalten Sie alle relevanten Updates zu GenAI – mit Fokus auf Kommunikation, Marketing und HR. Hier kostenlos abonnieren.

6. Was gilt laut AI Act für Unternehmen hinsichtlich ihrer KonzernGPTs?

Viele Unternehmen haben eigene Chatbots, sogenannte KonzernGPTs, entwickelt. In den meisten Fällen basieren sie auf ChatGPT – sind allerdings so gebaut, dass eingegebene Daten nicht zum Training des LLMs genutzt werden und teilweise sogar noch nicht einmal über US-Server laufen. Das ermöglicht dann eine DSGVO-konforme Nutzung.

Der AI Act thematisiert KonzernGPTs nicht ausdrücklich. Es gibt jedoch bereits Diskussionen unter Expert:innen, dass es sich bei den Weiterentwicklungen des GPTs ja nicht um eigene KI-Anwendungen handelt, sondern dass nur die eingegebenen Daten anders (nämlich datenschutzkonform) verarbeitet werden. Demnach würden daraus keine besonderen Verpflichtungen laut AI Act erwachsen.

Wenn Unternehmen jedoch eigene KI-Anwendungen wie Chatbots im Kundenservice oder Bilddatenbanken entwickeln, dann fallen diese definitiv auch unter den AI Act.

Vielversprechend aus Unternehmenssicht ist eine weitere Vorgabe der EU unter der Überschrift „Innovation“: dass das Gesetz nämlich KMU und Start-ups ermöglichen soll, eigene KI-Modelle zu entwickeln und zu trainieren, bevor sie für die allgemeine Öffentlichkeit freigegeben werden. Dazu müssen die nationalen Behörden Unternehmen eine realitätsnahe Testumgebung zur Verfügung stellen. Wie diese aussehen, ist allerdings noch völlig offen.

7. Gibt es im AI-Act Sonderregeln für die besonders leistungsstarken KI-Chatbots?

Die gibt es tatsächlich – allerdings nur für Hersteller und Betreiber, nicht – und das ist für Unternehmen wichtig – für reine Nutzer. Im Laufe der Entwicklung des AI Acts hat die Politik, getrieben durch den Erfolg von KI-Chatbots in 2023, nochmals separate Anforderungen für sogenannte General Purpose AI (GPAI) angestoßen – damit wird die reine Risikoklassifizierung aufgeweicht.

GPAIs sind demnach KI-Systeme, die verschiedene Aufgaben bewältigen können. Während manche GenAI-Tools spezielle Zwecke erfüllen, bspw. die Übersetzung von Text, sind GPAIs breiter angelegt. Das bekannteste GPAI ist ChatGPT, das diverse Importe verarbeiten kann – von Text über Bilder und Code bis zu Sprache – und auch unterschiedliche Medien ausgibt.

Anbieter dieser besonders leistungsfähigen, multimodalen KI-Modellen müssen in Zukunft über Strategien verfügen, dass sie das Urheberrecht beim Trainieren ihrer Modelle einhalten. Bisher, so zumindest die Sicht vieler Verlage, Autoren und Content-Datenbanken, haben Anbieter wie OpenAI die Urheberrechte ignoriert. Die genauen Regelungen für GPAIs sollen bis Juli 2025 in einem separaten „Code of Practice“ formuliert werden.

Ursprünglich sollte dieser sogar schon im Mai veröffentlicht werden – die Abstimmungen zwischen Brüssel und den großen US-Tech-Konzernen im Sinne einer einvernehmlichen Lösung dauerten jedoch länger. Kritiker monierten direkt, die EU lasse sich von Google, OpenAI, Microsoft zu sehr reinreden.

Wichtig beim Code of Practice ist: Diese Verschärfung betrifft nicht die Nutzer (im Sprech des AI Acts „Betreiber“), sondern nur die Anbieter von GPAI.

8. Schafft der AI Act endlich Klarheit, wie KI mit Urheber- und Nutzungsrechten umzugehen hat?

Jein. Ein derart umfassendes Gesetzeswerk hat nicht die Aufgabe, die konkreten juristischen Auslegungen im Detail zu definieren, aber es soll einen Rahmen setzen, in dem sich künftig Rechtssprechung bewegt. Und das tut der AI Act, gerade mit Blick auf GPAIs, also leistungsfähige Sprachmodelle.

Der Entwurf sieht vor, dass Betreiber nicht nur den Trainings- und Testprozess des Modells offenlegen, sondern auch „die Art und Herkunft der Daten“ sowie, „wie die Daten erhalten und ausgewählt wurden“. Zudem müssen KI-Firmen laut Art. 52c sicherstellen, dass sie die Urheberrechte in der EU einhalten und Daten, welche die Eigentümer nicht freigeben wollen, auch garantiert nicht in ihre Modelle einfließen lassen.

„Urheberrechte in der EU einhalten“ klingt sehr absolut. Allerdings krankt die Forderung daran, dass schlichtweg noch nicht geklärt ist, ob GenAI-Tools überhaupt einen Urheberrechtsverstoß begehen, da sie (in der Tat) urheberechtlich geschützte Inhalte ja nicht 1:1 wiedergeben, sondern die Informationen neu zusammenwürfeln

Auf dieser Basis werden Richter:innen in den nächsten Jahren entscheiden müssen, wie konkrete Fälle von Urheber- oder Nutzungsrechts-Streitigkeiten zu bewerten sind. Heißt: Die Rechtssprechung muss sich noch entwickeln. Und auch wenn sie zugunsten der Rechteinhaber ausfallen dürfe, heißt das noch lange nicht, dass die KI-Konzerne klein beigeben: Der seit Jahren schwele Rechtsstreit zwischen Google und Verlagen darüber, wie viel Tantieme der Suchmachinenbetreiber für die Nutzung der Inhalte zu zahlen habe („Leistungsschutzrecht“), taugt hier als Präzendenzfall.

Für Unternehmen dürfte in diesem Zusammenhang eine Frage interessant werden: Ob sie einen generellen Anspruch haben, von Mitarbeitenden erstellte Daten in eigene KonzernGPTs einzuspeisen. Setzt man sie mit den Anbietern von Sprachmodellen gleich, müssten sie sicherstellen, dass Inhalte einzelner Nutzern auf deren Wunsch entfernt bzw. nicht integriert werden. Auch hier gibt es aber noch keine belastbare Rechtsauslegung.

9. Müssen Unternehmen ihre Mitarbeiter:innen in puncto KI schulen?

Wenn Unternehmen selbst KI-Lösungen entwickeln und die Mitarbeitenden diese anwenden, dann sollten sie dies tun: Der AI Act legt in Art. 4b fest, dass Anbieter KI-Kompetenz beim eigenen Personal und bei Dienstleistern sicherstellen müssen. Diese „AI literacy“ ist seit Februar 2025 verpflichtend – und das für quasi alle Unternehmen, die KI oder GenAI einsetzen. Ausnahmen gibt es laut EU nicht, weder was Firmengröße noch was Tool-Set angeht.

Alle Firmen müssen „so weit wie möglich sicherstellen, dass ihr Personal (…) über ausreichende KI-Kenntnisse verfügen“, so das EU-Gesetz. Dabei seien „technische Kenntnisse, Erfahrung, Aus- und Weiterbildung und des Kontexts, in dem die KI-Systeme eingesetzt werden sollen“, zu beachten. Da das Thema so aktuell ist, behandeln wir es hier in einem eigenen Beitrag zur Schulungsverpflichtung.

10. Drohen Strafen, wenn Unternehmen die Regeln im KI-Gesetz nicht einhalten?

Ja, die EU hat sogar hohe Bußgelder angekündigt. Als Höchststrafe sind 7 Prozent des gesamten weltweiten Vorjahresumsatzes oder 35 Millionen Euro vorgesehen. Zum Vergleich: DSGVO-Verstöße kosten „nur“ maximal 4 Prozent des Umsatzes oder 20 Millionen Euro. Aktuell (Q2/2025) sind allerdings noch keine Strafverfahren bekannt.

11. Braucht nun jedes Unternehmen einen „KI-Beauftragten“?

Juristisch ist das leicht zu verneinen. Der AI Act verlangt, anders als wie ehedem die DSGVO, keinen Aufseher, also kein Äquivalent zum Datenschutzbeauftragten. Wir raten Unternehmen sogar ab, die Zuständigkeit für KI bei nur einem/einer Beauftragten zu bündeln, denn jede:r Mitarbeitende sollte über ausreichend KI-Wissen und ein entsprechendes Mindset verfügen, um die neue Technologie produktiv und zugleich reflektiert einzusetzen. Lesenswert in dem Kontext ist ein Bericht der FAZ: Sie warnt vor den Nachteilen eines KI-Beauftragten. Denn laut FAZ zeigen Forschungsergebnisse, dass andere Mitarbeiter:innen das Thema KI sogar eher von sich wegschieben, wenn ein Verantwortlicher benannt wird.

Was der AI Act allerdings verlangt, das ist KI-Kompetenz: Anbieter und Betreiber von KI-Systemen müssen ihr Personal schulen – hier haben Unternehmen „nach bestem Wissen und Gewissen“ eine Pflicht zur KI-Ausbildung (siehte 9.)

12. Reguliert der AI Act auch die private Nutzung?

Der AI Act gilt nur für professionelle Anwender – wer KI-Systemen zu privaten Zwecken einsetzt oder entwickelt, muss sich um diese EU-Gesetzgebung nicht kümmern. Dies gilt auch für die Nutzung von Generativer KI in Schule oder Universität. Je nach Bildungsinstanz gelten hier jedoch individuelle Regeln, was Transparenz oder den generellen Einsatz von KI-Tools angeht. Der AI-Act allerdings verbietet diesbezüglich nichts.

13. Ab wann gilt der AI Act?

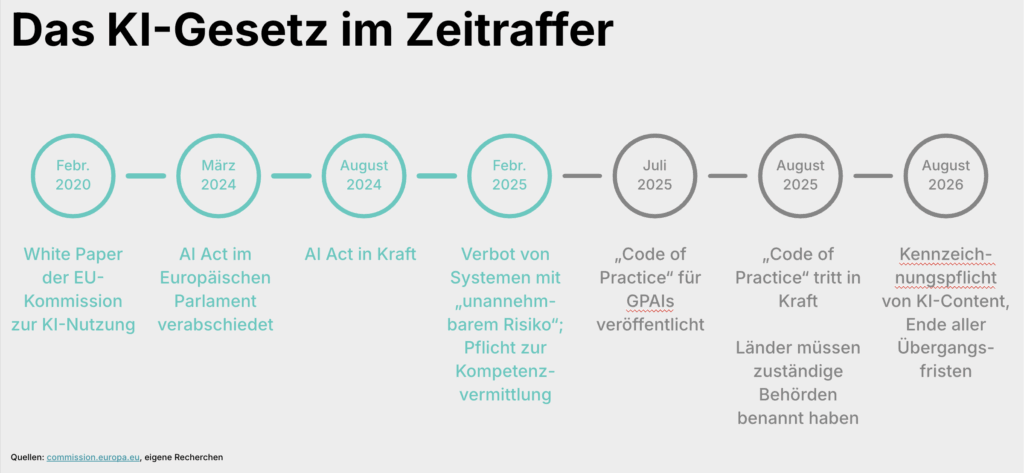

Auch wenn sie bereits im Sommer 2024 von den EU-Gremien beschlossen worden ist, ist die KI-Verordnung noch nicht vollständig in Kraft. unsere Grafik zeigt die wichtigsten Schritte:

Wie man sieht, greifen einige Regeln erst nach 24 Monaten, während andere bereits im Februar 2025 in Kraft getreten sind.

14. Was sollten Unternehmen jetzt tun?

Konsequenzen hat der AI Act der EU für Unternehmen, egal ob sie selbst KI entwickeln oder nicht. Denn er reguliert eben auch Nutzer:

- Zunächst braucht es eine Bestandsaufnahme – welche KI-Systeme sind im Einsatz oder vorgesehen, und wie lassen sich sie entsprechend der Kategorisierung des AI Acts einsortieren? Eine schriftlich dokumentierte „KI-Inventur“ ist mit Blick auf eventuelle zukünftige Prüfungen sehr empfehlenswert.

- Wenn Anwendungen als transparenz-/kennzeichnungspflichtig oder sogar als Hoch-Risiko-KI gelten können, dann sollten Unternehmen rasch reagieren und die EU-Vorgaben umsetzen. Dazu zählen professionelle KI-Guidelines und KI-Weiterbildung für alle Mitarbeiter:innen – und das so schnell wie möglich, da dies seit Februar 2025 gilt.

Spätestens mit dem AI Act wird für Unternehmen das Thema KI eines, das die Gesamtorganisation und das Management betreffen muss. Insofern ist jetzt der richtige Zeitpunkt – wenn nicht schon geschehen – um eine eigene KI-Strategie zu entwickeln. - Diese muss natürlich die Risiken der Technologie im Blick haben, sich vor allem aber den Chancen von Künstlicher Intelligenz/GenAI widmen. Denn mit dem AI Act als stabilem rechtlichen Fundament wird die KI-Entwicklung nochmals an Tempo zulegen – spätestens jetzt sollte jedes Unternehmen KI zur Chefsache machen.

Bei uns finden Sie für Ihr Team die passenden KI-Seminare

In unseren individuellen KI-Seminare erhalten Einsteiger und Profis praktisch nutzbares Wissen zu GenAI, üben den Umgang mit relevanten Tools und erfahren wichtige Hintergründe. Wir schulen in deutscher und englischer Sprache. Hier geht’s zur Seminar-Übersicht.

Hinweis: Dieser Text über den AI Act für Unternehmen basiert auf gründlichen Recherchen und Gesprächen mit Expert:innen, ist aber keine belastbare juristische Bewertung. Wir übernehmen keine Haftung für eventuelle Fehleinschätzungen. Beachten Sie zudem, dass es sich beim AI Act um ein laufendes Gesetzgebungsverfahren handelt. Änderungen an den genannten Anforderungen sind möglich.

Bildquelle: Midjourney/disruptive